Upozorenje korisnicima: Ovih 5 stvari nikada ne otkrivajte ChatGPT-u!

Veštačka inteligencija je sve više prisutna u našim životima i svakim danom se sve više koristi, a popularnost AI chatbot aplikacija, kakve su ChatGPT i Google Gemini, stalno raste.

Ovi chatbot-ovi ljudima su privlačni zbog svoje sposobnosti da, na postavljena pitanja, generišu odgovore veoma bliske ljudskoj komunikaciji. Međutim, njihovo oslanjanje na velike jezične modele (LLM) nije bez rizika, pa je važno razumeti da neke podatke i informacije nikada ne bi trebalo deliti sa AI chatbot-ovima.

Naime, lični podaci korisnika podeljni sa AI chatbot-ovima mogu biti otkriveni i zloupotrebljeni, pre svega, zbog toga što se mogu se naći među podacima koji se koriste za treniranje drugih AI botova. Do njih tada mogu da dođu i kod kompanije koji stoje iz ovih AI alata i njihovih partnera, kao i hakeri, ako provale u sistem.

Zato, ovih 5 vrsta podataka nikada ne bi trebalo da delite sa veštačkom inteligencijom:

1. Podaci o finansijama

Ako AI chatbot-ove koristite kao lične finansijske savetnike, rizikujete da informacije o svojim finansijama izložite sajber kriminalcima koji bi to mogli da iskoriste da isprazne vaše račune ili da ih zloupotrebe za druge vrste prevara.

Uprkos tome što kompanije često tvrde da su podaci iz konverzacije korisnika i AI-ja anonimni, neki zaposleni u tim kompanijama ili njihovi partneri treće strane bi i dalje mogli da imaju pristup njima.

Chatbot bi, na primer, mogao da analizira potrošačke navike korisnika da bi mu ponudio savete, ali ako tim podacima neko pristupi neovlašćeno, oni bi mogli biti zloupotrebljeni da onoga čiji su profilišu kao prevaranta, npr. da budu iskorišćeni za phishing imejlove koje imitiraju vašu banku.

2. Šifre

Deljenje lozinki različitih naloga na internetu je generalno rizično, na šta stručnjaci za sajber bezbednost stalno upozoravaju. Isto važi i za velike jezične modele na kojima se AI chatbot-ovi zasnovani, pa se takvim potezom izlažete velikim rizicima.

Zato, da biste se zaštitili, šifre svojih onlajn naloga nikada ne delite sa chatbot-ovima, čak ni kada bi to moglo da bude u svrhu rešavanja nekog problema.

3. Poverljive informacije o radnom mestu

Tehnološki giganti Apple, Samsung i Google svojim zaposlenima su ograničili upotrebu AI chatbot-ova na radnom mestu, nakon što su te kompanije primetile slučajeve nenamernog objavljivanja osetljivih informacija u komunikaciji sa veštačkom inteligencijom.

Tako je jedan programer u Samsungu koristio ChatGPT kao pomoć u kodiranju i time nehotice podelio osetljiv kod sa generativnim AI-jem. Mnogi zaposleni se oslanjaju na chatbot-ove da bi sumirali zaključke poslovnih sastanaka ili automatizuju repetitivne zadatke koji se ponavljaju, ali time ulaze u rizik od izlaganja osetljivih podataka, piše Smartlife.

Zbog svega toga, veoma je važno voditi računa o rizicima vezanim za deljenje podataka u vezani sa poslom, ističe MakeUseOf.

4. Adresa i drugi lični podaci

Osetljivi lični podaci kao što su adresa i mesto stanovanja, datum rođenja, matični broj ili podaci o zdravlju, mogu biti iskorišćeni za identifikaciju i lociranje njihovog vlasnika, pa ih je zato potrebno zadržati za sebe uvek kada je to moguće.

Zato je potrebno upoznati se sa pravilima privatnosti chatbot-a da bi se razumeli rizici. Zato izbegavajte postavljanje pitanja koja nenamerno mogu da otkriju identitet i/ili lične podatke. Budite posebno oprezni i uzdržite se od deljenja medicinskih podataka.

5. Lično stanje i intimne misli

AI chatbot-ovi možda mogu da budu dobri sagovornici, ali im nedostaje znanje o stvarnom svetu, zato na npr. pitanja o (mentalnom) zdravlju mogu da ponude samo generičke odgovore.

To znači da lekovi ili tretmani koje predlažu možda nisu adekvatni za specifične potrebe korisnika i da mogu da budu štetni po zdravlje.

To takođe važi i za upozorenja u vezi sa zaštitom privatnosti. Ako se neko zlonameran dokopa vaših intimnih misli, vaša privatnost može biti kompromitovana, a intimne misli iskorišćene kao podaci za treniranje veštačke inteligencije.

Zbog svega toga AI chatbot-ove treba koristiti za razmenu opštih informacija i znanja, i od njih ne očekivati profesionalnu podršku ili terapiju.

Najnovije iz Hi-Tech

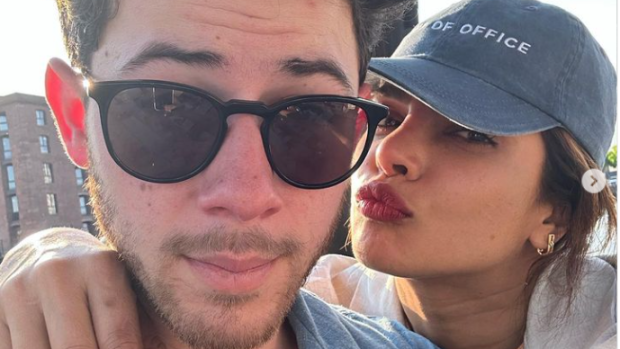

Prijanka Čopra komentarisala priče o razvodu od Nika Džonasa: „Ljudi žele da čuju da se sve raspada“

„Možda je to bila samo strast“: Zejn Malin iznenadio izjavom o ljubavi sa Điđi Hadid

Kejti Holms se emotivnom porukom oprostila od Džejmsa Van Der Bika (FOTO)

Britni Spirs prodala prava na sve svoje hitove: Ugovor se procenjuje na 200 miliona evra

Šakira doživela nezgodu tokom nastupa: Pevačica pala na bini, a njena reakcija je hit (VIDEO)

Komentari (0)

Trenutno nema komentara. Budite prvi i ostavite komentar.